2024.11.07

2024.11.07

在具身智能技术驱动下,人形机器人正从预设型机械作业模式向环境自适应智能模式跃迁,其核心挑战在于通过类人形态突破场景边界,实现家庭服务、工业协作、特种救援等复杂场景的无缝介入。作为物理交互的核心载体,上肢拟人化操作系统的性能将直接决定人形机器人的动态环境适应能力,但当前技术体系仍面临高维运动空间动态解耦困难、多模态感知-决策闭环构建滞后、非结构化环境操作鲁棒性不足等瓶颈,导致人形机器人上肢系统仿人形态与类人智能割裂,难以复现人类上肢的灵巧运动特性。

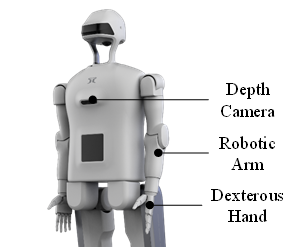

为解决上述问题,研究团队构建了感知、规划、执行全栈式技术框架。首先,研究团队设计了一种分层级视觉感知算法,通过从目标粗筛到关键点细判的协同优化策略,实现动态场景下的高精度抓取点定位,显著提升复杂背景干扰下的抓取点检测鲁棒性。其次,采用动态运动基元从人类示范数据中开展参数学习,同时结合实时传感器反馈进行在线空间泛化与时间泛化,实现更符合人类直觉预期的类人运动规划。最后,提出一种接触映射引导的阻抗自适应抓取执行方法,通过条件变分自动编码器生成手物交互接触映射,从几何与摩擦特性出发求解灵巧手最优抓取手势,并采用基于位置的阻抗控制动态调节抓取力,从而实现上肢系统的自适应稳定抓取。

本研究攻克了人形机器人上肢在复杂多目标场景下的感知、决策与执行协同难题,实现拟人化的灵巧操作能力,为人形机器人从单一任务执行向多目标自主作业演进提供关键技术支撑。

人形机器人研究中心的刘天雨和多模态感知研究室田蓥梅为论文共同第一作者,清华大学深圳国际研究生院刘厚德教授为论文通讯作者,该工作得到了江淮中心自主科研项目的资助。

0551-65387203

0551-65387203

Qjznjqr@163.com

Qjznjqr@163.com

安徽省合肥市高新技术开发区望江路920号 中安创谷科技园二期H3/H4/H5/H6/H7/H8幢

安徽省合肥市高新技术开发区望江路920号 中安创谷科技园二期H3/H4/H5/H6/H7/H8幢